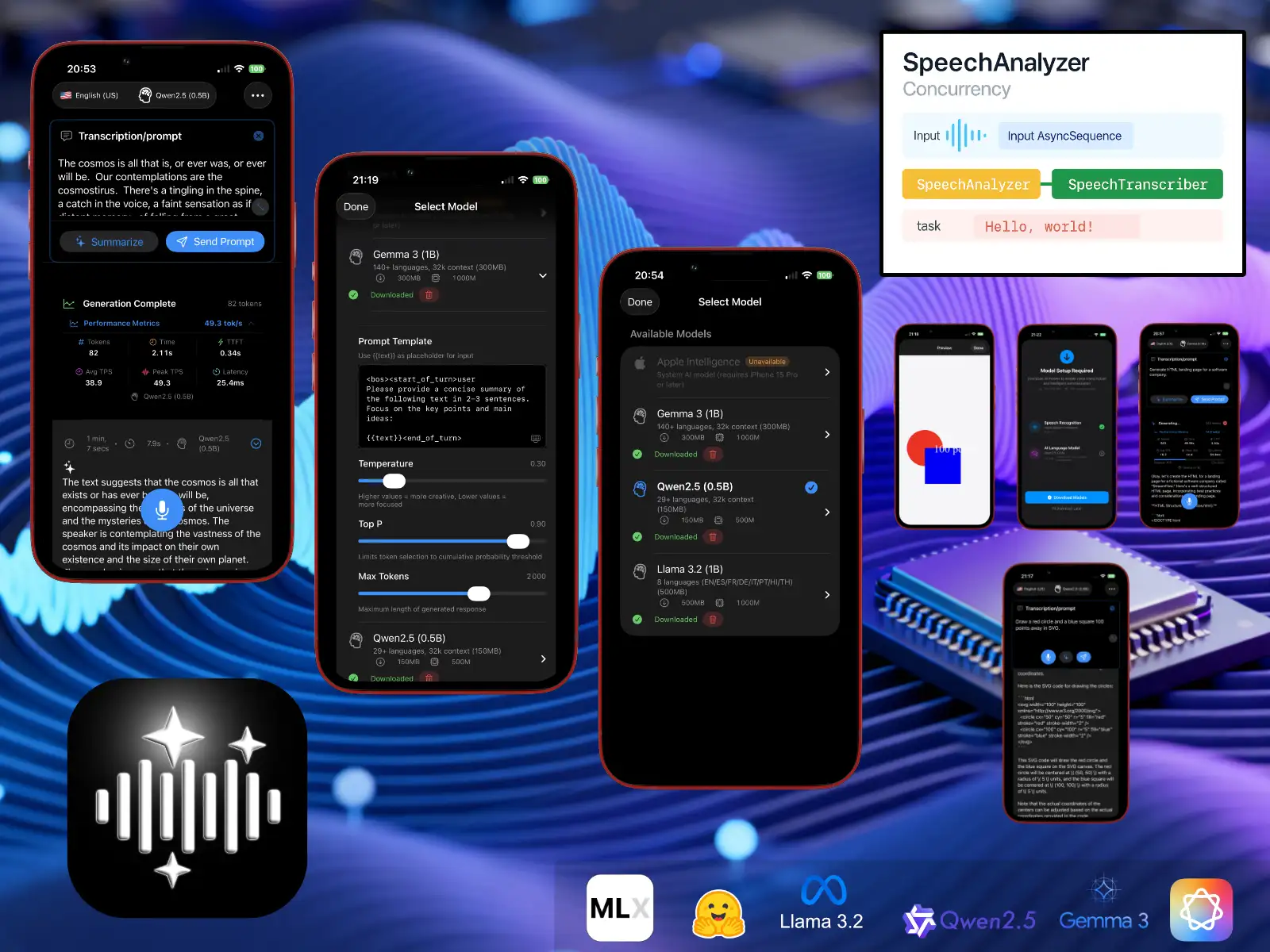

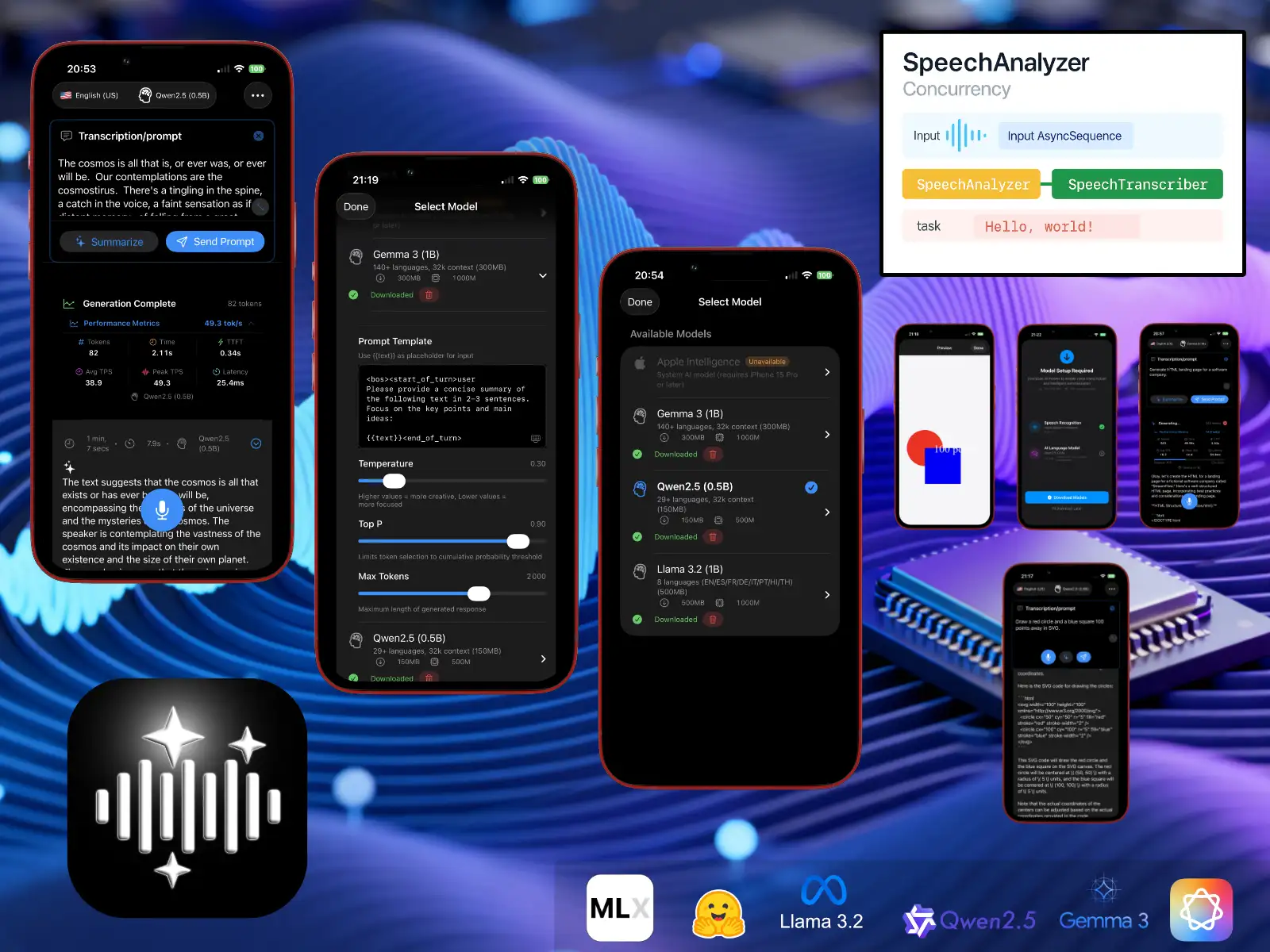

LLMVoice 1.0

Voici LLMVoice, une démo technique permettant d’évaluer les nouvelles API de reconnaissance vocale d’iOS 26 (SpeechAnalyzer / SpeechTranscriber) et l’exécution de modèles LLM open-weights (quantifés en 4bits) en local sur un iPhone supportant le framework MLX. Vous pouvez soit résumer une transcription ou envoyer un prompt directement au modèle.

Autant être clair, des modèles aussi compressés ne sont pas réellement utiles, c’est quand même divertissant de les voir halluciner. Mais il a quand même de quoi mettre mon antique iPhone 13 à genoux !

Voici les modèles disponibles en téléchargement :

Gemma3_1b (mlx-community/gemma-3-1b-it-4bit)

Qwen25_05b (lmstudio-community/Qwen2.5-0.5B-Instruct-MLX-4bit)

Llama32_1b (mlx-community/Llama-3.2-1B-Instruct-4bit)

Code source

Code source LLMVoiceConfiguration requise

iOS 26.0+ / iPadOS 26.0+

Pour Apple Intelligence

iPhone 15 Pro ou modèle ultérieur Apple Intelligence activée dans les réglages

Pour les modèles locaux MLX

iPhone 12 ou modèle ultérieur (puce A14 Bionic ou supérieure).

iPad Pro 2021 ou modèle ultérieur (puce M1 ou supérieure).

iPad Air 5ᵉ génération ou modèle ultérieur (puce M1 ou supérieure).

GPU Metal avec fonctionnalités spécifiques : air.simd_sum, prise en charge du noyau rmsfloat16.

Stockage

Taille de l’application : environ 50 Mo Téléchargements de modèles (MLX uniquement) :

Qwen2.5 (0,5B) : environ 150 Mo

Gemma 3 (1B) : environ 300 Mo

Llama 3.2 (1B) : environ 500 Mo

🛟 Support

Besoin d’aide ou envie de partager un retour ? Écris à support@andrefrelicot.dev.