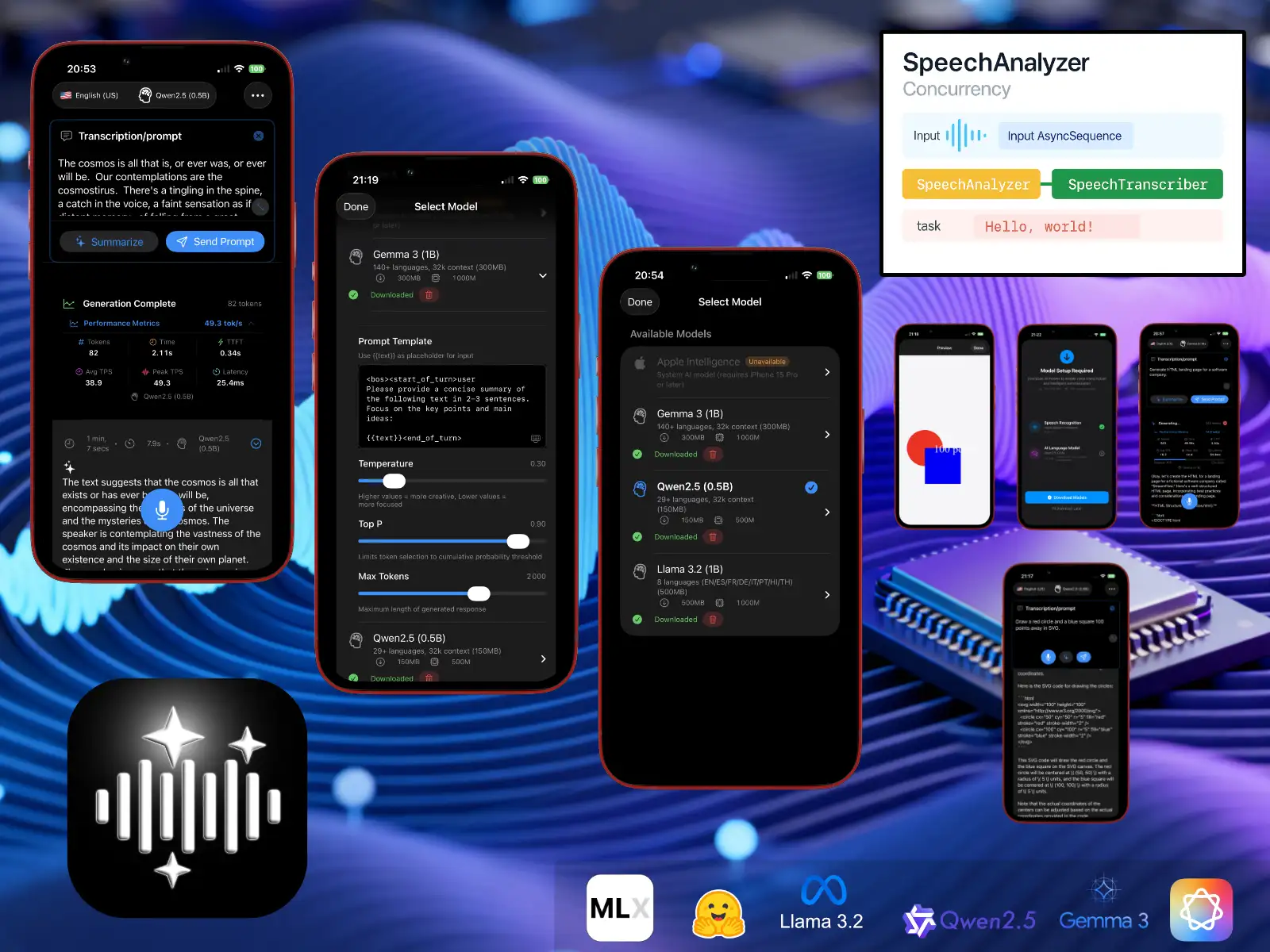

LLMVoice 1.0

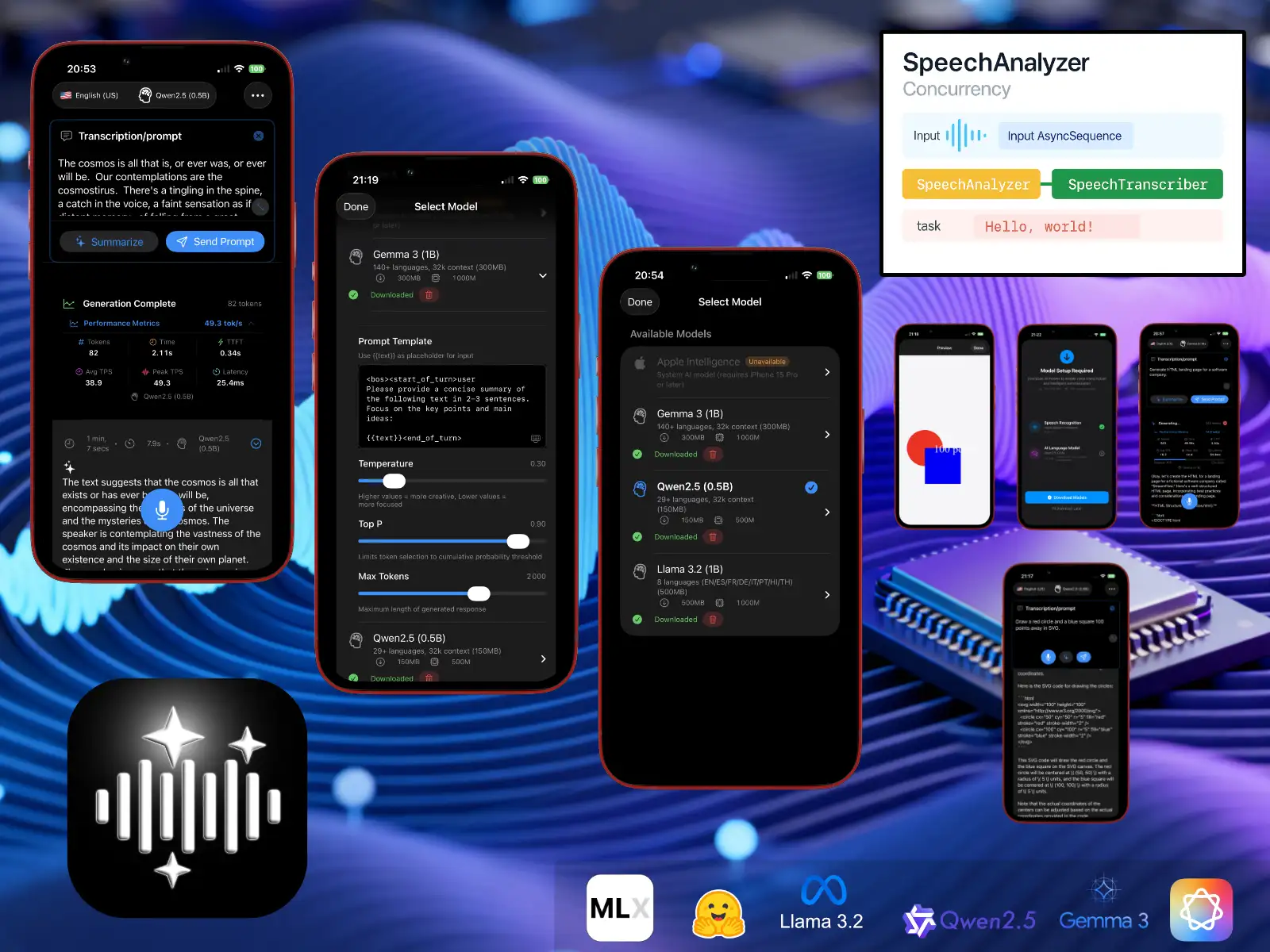

Aquí está LLMVoice, una demostración técnica que permite evaluar las nuevas API de reconocimiento de voz de iOS 26 (SpeechAnalyzer / SpeechTranscriber) y la ejecución de modelos LLM de código abierto (cuantificados en 4 bits) localmente en un iPhone compatible con el framework MLX. Puedes resumir una transcripción o enviar un prompt directamente al modelo.

Seamos claros: modelos tan comprimidos no son realmente útiles, pero sigue siendo divertido verlos alucinar. ¡Aun así, logran poner de rodillas a mi viejo iPhone 13!

Estos son los modelos disponibles para descargar:

Gemma3_1b (mlx-community/gemma-3-1b-it-4bit)

Qwen25_05b (lmstudio-community/Qwen2.5-0.5B-Instruct-MLX-4bit)

Llama32_1b (mlx-community/Llama-3.2-1B-Instruct-4bit)

Código fuente

Código fuente LLMVoiceRequisitos del sistema

iOS 26.0+ / iPadOS 26.0+

Para Apple Intelligence

iPhone 15 Pro o modelo posterior

Apple Intelligence activado en los ajustes

Para los modelos locales MLX

iPhone 12 o modelo posterior (chip A14 Bionic o superior).

iPad Pro 2021 o modelo posterior (chip M1 o superior).

iPad Air de 5ª generación o modelo posterior (chip M1 o superior).

GPU Metal con características específicas: air.simd_sum, compatibilidad con el núcleo rmsfloat16.

Almacenamiento

Tamaño de la aplicación: aproximadamente 50 MB

Descargas de modelos (solo MLX):

Qwen2.5 (0,5B): aproximadamente 150 MB

Gemma 3 (1B): aproximadamente 300 MB

Llama 3.2 (1B): aproximadamente 500 MB

🛟 Soporte

¿Necesitas ayuda o quieres compartir comentarios? Escribe a support@andrefrelicot.dev.